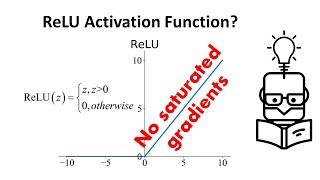

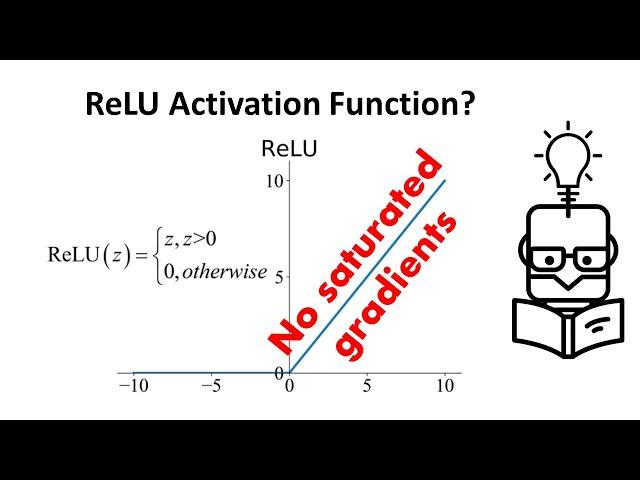

Why ReLU Is Better Than Other Activation Functions | Tanh Saturating Gradients

Комментарии:

Dans eden kızlar karma

Dansfobik

The Traveling WIlburys - Last Night (Official Visualizer)

The Traveling Wilburys

Learn English in 30 Minutes - ALL the English Basics You Need

Learn English with EnglishClass101.com

7 BEST High Yield Savings Accounts of September 2024

Milan Singh | Finance

Roblox bloxburg donation limit problem

Gaming imgn